La extinción del anonimato

Paga tu factura con una sonrisa, desbloquea tu teléfono solo con mirarlo. Suena emocionante, un poco preocupante y, vistas las aplicaciones e implicaciones de la tecnología, también aterrador. Cámaras, siempre encendidas, instaladas en todos los sitios, desde coches a timbres, en tu teléfono móvil. Así está el mundo: casi todo lo que haces, dondequiera que vayas, las personas con las que te asocias, todo lo que compras o miras, e incluso piensas comprar, todo se registra, se puede rastrear y analizar, a escala masiva, con propósitos inimaginables y horribles.

La tecnología biométrica permite el seguimiento automatizado y generalizado de toda una población. Existe amplia evidencia científica de que este tipo de recopilación y análisis masivo de datos de arrastre no es útil para la seguridad pública, pero es perfecto para la opresión y el control social. Porque la vigilancia facial de nuestro comportamiento, si es persistente, genera conformidad, beneficia a los tiranos y enriquece a las élites. Achica los espacios libres de intrusión gubernamental tan necesaria para poder avanzar como civilización. Porque sin libertad, sin desviarse de las normas, sin disentir de la autoridad, el progreso social se detiene.

¿Preocupada? Tienes motivos. Las cosas están a punto de volverse mucho más aterradoras a menos que se establezca, si ya no es demasiado tarde, una nueva regulación, o quizá mejor, una prohibición definitiva. La tecnología de identificación facial ya se está utilizando para vigilar espacios públicos y protestas, para rastrear y perfilar a minorías sociales, para señalar a sospechosos en investigaciones criminales, para avergonzar en público a infractores de las normas. Los viajeros, los fans, los hinchas… todos vigilados.

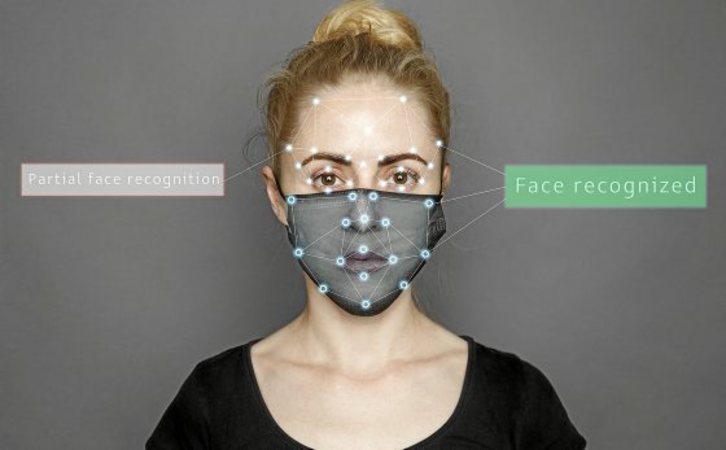

Enraizado en teorías desacreditadas de pseudociencia y eugenesia racista que afirman usar la estructura facial y la forma de la cabeza para evaluar la capacidad mental y el carácter, el software de reconocimiento facial automatizado utiliza inteligencia artificial, aprendizaje automático y otras formas de computación moderna para capturar los detalles de las caras y comparar esa información con las bases de datos de fotografías existentes con el objetivo de identificar, verificar, categorizar y localizar personas.

Solo utilizan la tecnología, según argumentan sus defensores, para monitorear las amenazas percibidas y predecir el comportamiento delictivo, pero las capacidades del reconocimiento facial son mucho más amplias. El software puede monitorear tu cuerpo a través de una combinación de biometría (mediciones de características físicas y de comportamiento), antropometría (mediciones de morfología corporal) y fisiometría (mediciones de funciones corporales como frecuencia cardíaca, presión arterial y otros estados físicos). Hablando claro, se trata de una tecnología para poder categorizar y diferenciar a las personas en jerarquías que determinan quién es capaz y quién no, quién es merecedor y quién no. Para poder controlar el comportamiento, una obra de ingeniería conductual a gran escala para poder crear un tipo de sociedad que les sea muy fácil de manejar.

Tecnología que da miedo. ¿Y si los gobiernos hubieran tenido hace 50 años esta vigilancia, cuando la homosexualidad todavía estaba criminalizada? En un mundo donde los espacios privados no existen, sin anonimato, ¿la gente homosexual se habría sentido lo suficientemente segura como para salir y reunirse, construir una comunidad y formar un movimiento?

El reconocimiento facial da miedo. Y se están preparando formas de vigilancia habilitadas por inteligencia artificial que van aún más allá: las empresas han comenzado a vender una gama de productos que intentan inferir y predecir tus emociones, tus intenciones y comportamientos «anómalos» a partir de tus expresiones faciales, de tu lenguaje corporal, tono de voz e incluso la dirección de tu mirada.

Aunque estas aplicaciones para el reconocimiento de emociones y comportamientos están en desacuerdo con estudios científicos que advierten que las expresiones faciales y otros comportamientos externos no son un indicador infalible de estados mentales o emocionales, eso no es lo que más preocupa. No, lo que aterra es su potencial para señalar minorías y poblaciones marginadas, para posibilitar su escrutinio injustificado, si la forma en que hablan, visten o caminan se desvía del comportamiento con el que el software ha sido programado para interpretar qué es lo normal, cuál es el estándar cultural.

¿Quién es el dueño de tu cara? Nuestras caras son fundamentales para nuestras identidades, son difíciles de ocultar. Nos miramos a la cara para comprender mejor los sentimientos y disposiciones más íntimas. Pero también son más fáciles de capturar que las huellas dactilares y el ADN, que requieren contacto físico o muestras. Además, la tecnología es fácil de usar y muy accesible, siempre lista para conectarse a las cámaras de la Policía y a otros sistemas.

El reconocimiento facial ofrece una visión aterradora de lo que podría llegar a ser la vigilancia, sobre cómo seguir el rastro de una persona y recopilar datos en tiempo real sobre su apariencia, paradero y actividades. Es cierto que también existen otras sospechas bien fundadas: esos algoritmos cometen muchos errores, especialmente cuando se trata de identificar mujeres y personas negras. Pero las empresas nos aseguran que ese sesgo es un error, no una característica, y que pueden solucionarlo.

Podrían tener razón, ¿por qué no? Los algoritmos mejorarán con el tiempo. Pero que sea más preciso no significa que deje de ser una amenaza menor. Esta tecnología es peligrosa, y a gran escala, aún más. Y seguirá perjudicando de forma desproporcionada a los más vulnerables. No será menos peligrosa a medida que sea más precisa, porque las grandes empresas, los gobiernos, e incluso tu vecino de al lado, querrán aplicarla en más lugares. Querrán identificarte y rastrearte, categorizar tus emociones, deducir dónde puedes comprar, protestar o trabajar, y usar esa información para controlarte y manipularte, o privarte de oportunidades.

El plutonio de la Inteligencia Artificial. Los enemigos de esta tecnología alegan que su uso es lo suficientemente peligroso como para prohibirlo, para casi todos los propósitos prácticos. Como las armas biológicas o nucleares, el reconocimiento facial plantea una amenaza tan grande para el futuro de la humanidad y para nuestros derechos básicos que cualquier beneficio potencial se ve superado por sus daños inevitables. Porque claro, hablamos de algo que no solo amenaza nuestra privacidad, también amenaza nuestra humanidad y nuestra capacidad de ser nosotros mismos.

La identificación facial es peligrosa, racializa, en la medida que ahonda en la práctica de producir razas, y tiene pocos usos legítimos. Por eso necesita una regulación y un control a la par que los residuos nucleares. Porque podría decirse que es el plutonio de la Inteligencia Artificial, o en otras palabras, arsénico en el suministro de agua.

Primero, por cómo funciona a nivel técnico, porque tiene fallas conectadas a la forma en que esquematiza los rostros humanos. Estos defectos crean y refuerzan categorizaciones en torno al género y la raza, con efectos socialmente tóxicos. Y luego, dado que sus riesgos superan ampliamente los beneficios, porque necesitaría controles tan, tan estrictos que sería mejor y más seguro prohibirla directamente.

Parte de la vida cotidiana. ¿Qué hace la compañía de tu teléfono móvil con esos escaneos de alta precisión, en 3D, de tu cara? Según dicen, nada de lo que tengas que preocuparte. Además, remarcan, es seguro: un sensor de huellas dactilares tiene una precisión aproximada de uno en 50.000, es decir, que si le das tu teléfono a 50.000 personas, solo una tendrá una huella digital lo suficientemente cercana como para desbloquearlo. Con la identificación facial, según nos informan las compañías, ese número es de uno en un millón.

¿Qué pasa si me dejo barba o me pongo una txapela? Tranquilidad, lleves barba, txapela o bufanda, te hayas rapado o no el pelo, el teléfono aprende a reconocerte con el tiempo. Y no solo puede detectar tu rostro, también lo que está haciendo. Verificará que tus ojos estén abiertos y mirando el teléfono. Nadie podrá sostenerlo frente a tu cara mientras duermes para acceder a tu información.

A medida que las personas se adaptan al uso rutinario de cualquier sistema de reconocimiento facial y este pasa a un segundo plano como otro aspecto, no muy destacable, de nuestras vidas contemporáneas y digitalmente mediadas, sus deseos y sus creencias pueden ser rediseñados. Por tanto, incluso si hubiera una prohibición y fuera efectiva hasta cierto punto, la tecnología todavía sería parte de la vida cotidiana. Y eventualmente tendríamos que lidiar con sus consecuencias.

¿Puertas al campo? Cada día hay más voces partidarias de prohibir el reconocimiento facial, tanto en el sector público como en el privado. Y de hacerlo antes de que seamos tan dependientes de esa tecnología que aceptemos sus inevitables daños como necesarios para el «progreso». Y quizá, quizá con el tiempo, se puedan promulgar políticas que justifiquen levantar esa prohibición, o no.

Pero sectores de la industria, legisladores e incluso algunos defensores de la privacidad se han mostrado escépticos sobre la prohibición. El primero de sus argumentos dice que los beneficios de toda nueva tecnología a menudo superan los daños. Dicen, que ahí están los ilegibles avisos sobre política de privacidad y descargos de responsabilidad, disponibles en todos los dispositivos. Que el afán prohibicionista es una reacción exagerada. Comparan a las personas que piden la prohibición con los detractores de antaño, cuyas ansiedades y paranoias por las nuevas tecnologías resultaron infundadas. Desde esta perspectiva, la tecnología de reconocimiento facial sería nada más y nada menos que la nueva huella dactilar.

Además, dejan caer una pregunta: si prohibimos ahora el reconocimiento facial, ¿qué pasará mañana cuando el reconocimiento de la marcha o los dispositivos que leen patrones cerebrales se generalicen? Ahí queda eso. En todo caso, es probable que muchas de esas preguntas se aborden en los más altos tribunales. Y conocida la velocidad del desarrollo tecnológico, una sociedad no puede esperar años para que los jueces actualicen protecciones y derechos en esta era digital. Ese esquema no funciona.

¿Cómo prohibir algo que está en todas partes? En medio del debate sobre el uso gubernamental o comercial del reconocimiento facial, muchas empresas siguen integrando la tecnología en una amplia gama de productos. Presentan más tecnología biométrica sin contacto, nuevos controles de acceso por reconocimiento facial. Formas aparentemente inocuas en las que se capturan nuestras imágenes, y al no tener mecanismos para protegernos, podrían usarse en nuestra contra.

Uno de los usos más populares es la verificación, generalmente para iniciar una sesión en dispositivos electrónicos. En lugar de escribir un código de acceso, una cámara frontal toma una foto del usuario y luego implementa algoritmos de reconocimiento facial para confirmar su identidad. En consolas de juegos, en ordenadores portátiles y en aplicaciones de todo tipo. Pero otras formas de reconocimiento facial van más allá de la verificación, no solo intentan identificar a su propio usuario, sino también a otras personas. Un ejemplo temprano: el etiquetado de fotos de Facebook. También está apareciendo en algunos televisores inteligentes que pueden reconocer qué miembro de una familia está frente a la pantalla y sugerir contenido personalizado.

Y hay posibilidades que van más allá de esas aplicaciones de consumo. Ya se escanean rostros con inteligencia artificial para evaluar a los solicitantes de empleo. Algunos autos usan biometría y cámaras para rastrear si los conductores se mantienen concentrados en la carretera, y varias compañías están explorando software que puede detectar emociones en un rostro. Aunque, claro, todo eso también puede introducir nuevos problemas de sesgo.

Por partes, poco a poco. Básicamente, los sistemas de reconocimiento facial tienen tres ingredientes: una imagen de origen, una base de datos y un algoritmo entrenado para hacer coincidir rostros en diferentes imágenes. A medida que los sistemas se vuelven más ambiciosos, que sus bases de datos se hacen más grandes y sus algoritmos se encargan de trabajos más difíciles, todo se vuelve más problemático. Y para hacernos una idea de la escala, igualmente descabellada en Pekín que en Londres, conviene recordar que el Centro de Privacidad y Tecnología de la Universidad de Georgetown descubrió en 2016 que más de la mitad de los estadounidenses están en una base de datos de reconocimiento facial.

La regulación del reconocimiento facial, de haberla, será gradual o no será. Y seguramente, una sola ley podría no ser suficiente. En EEUU, la Ley de Moratoria de Reconocimiento Facial y Tecnología Biométrica recientemente introducida en el Capitolio prohibiría el uso federal no solo del reconocimiento facial, sino también de otros tipos de tecnologías biométricas, como el reconocimiento de voz y el de la marcha, como mínimo hasta que el Congreso apruebe otra ley que regule la tecnología. La Ley de Privacidad de Reconocimiento Facial Comercial pretende obligar el consentimiento explícito y la Ley de Responsabilidad Algorítmica requeriría que las grandes empresas verifiquen su inteligencia artificial, incluidos los sistemas de reconocimiento facial, en busca de sesgos.

Pero no hay bala mágica ni golpes de suerte. Una sola ley no da para todo eso. Esa tecnología debería ser regulada y controlada por una oficina, similar a la Alimentos y Medicamentos, una nueva agencia que podría adaptarse a la amplia gama de usos gubernamentales, corporativos y privados de la tecnología. Y quizá así los consumidores tendrían la protección de un marco regulador.

Signos preocupantes de sesgo. La tecnología se extiende rápidamente; la reacción ante ella, también. El aumento de los dispositivos de consumo equipados con funciones de reconocimiento facial contrasta con la creciente presión para regular e incluso prohibir su uso. En su día la favorita de Silicon Valley, con aplicaciones para la vigilancia, el espionaje y la autenticación de identidades, está repentinamente bajo fuego cruzado. Varias ciudades ya han prohibido la vigilancia biométrica. Otras tienen ordenanzas, se está gestando legislación, en la Unión Europea, en EEUU o en China. IBM, Microsoft… los gigantes anuncian moratorias.

Y otros deberían seguir su ejemplo. Por ejemplo, Amazon. Su patrón, Jeff Bezos, que apoyó recientemente al movimiento Black Lives Matter, ha estado vendiendo su software de reconocimiento facial “Rekognition” –que ha mostrado repetidamente signos preocupantes de sesgo– a las fuerzas del orden de los EEUU desde 2016. En 2018, la Unión Estadounidense de Libertades Civiles (ACLU) publicó un informe que mostraba cómo había identificado erróneamente a miembros afroamericanos del Congreso, incluido el icono de los derechos civiles recientemente fallecido, John Lewis, como personas que antes habían sido detenidas y tenían su fotografía en una base de datos policial.

«Casi el 40% de las coincidencias falsas de ‘Rekognition’ en nuestra prueba fueron de personas de color, a pesar de que representan solo el 20% del Congreso», decía el informe de ACLU. Un estudio de 2011 de la Universidad de Texas en Dallas encontró que el software desarrollado en Asia Oriental reconocía a los asiáticos orientales mejor que a los caucásicos (término que describe una raza humana según la clasificación de Johann Friedrich Blumenbach, que básicamente corresponde a lo que otros llaman «raza» blanca).

Reencarnación del Gran Hermano. De manera rutinaria, cedemos el acceso de las compañías a nuestros registros personales y bancarios, a nuestros patrones de compra y nuestra ubicación exacta en el planeta. Pero luego, no queremos que nuestros rostros se almacenen en vastas bases de datos, ya sean públicas o privadas. Ahora se habla mucho de la inexactitud, pero es posible que no sea por mucho tiempo el problema más grave. La tecnología está mejorando todo el tiempo y millones de personas ayudan a mejorarla. Cualquiera que desbloquee su teléfono apuntando a la cara ya confía que funcionará lo suficientemente bien. Cualquiera que se haya etiquetado, o a sus amigos, en una foto en redes sociales, también.

No son solo los gobiernos los interesados. El software está disponible y es barato. Se distribuye por todo el Internet de las Cosas, desde los intercomunicadores hasta los asistentes domésticos. Nos hemos acostumbrado, renunciamos a nuestra privacidad, la tecnología que puede ser benigna y beneficiosa, aunque pueda retorcerse hasta permitir calamidades y desgracias inimaginables.

Imagina tu nombre y tu foto en una valla publicitaria por haber cruzado imprudentemente un semáforo, o que el Gobierno te envíe un mensaje de texto por comportarte como te comportas. Una vez que esa tecnología se haga abrumadora y sea percibida como «fiable», el mundo distópico de vigilancia gubernamental será realidad. El Gran Hermano gobernará y está por ver si podremos ser nosotros mismos.